引言

随着大数据时代的到来,HBase作为Apache Hadoop生态系统中的分布式NoSQL数据库,已经成为了处理大规模结构化数据的首选之一。而Apache Spark,作为一种快速、通用的大数据处理引擎,其强大的数据处理能力与HBase的灵活性和可扩展性相结合,能够实现高效的数据处理。本文将探讨如何使用Spark与HBase高效地协同工作,以提高数据处理的效率。

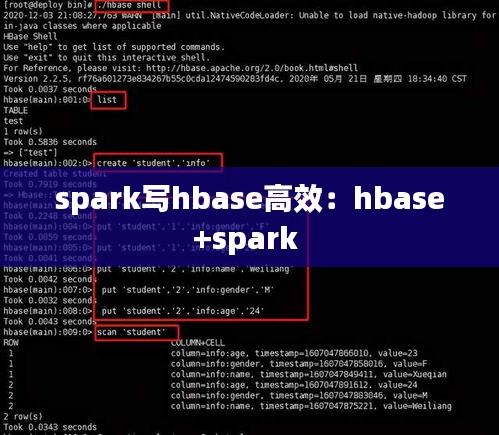

Spark与HBase的集成

要实现Spark与HBase的高效集成,首先需要确保两者之间的通信顺畅。以下是一些关键的集成步骤:

安装HBase客户端库:在Spark应用中,需要添加HBase的客户端库,以便能够与HBase集群进行交互。

配置HBase连接:通过配置文件或代码设置HBase连接参数,如ZooKeeper的地址、HBase的根目录等。

使用HBase API进行操作:通过HBase的Java API或Scala API,可以在Spark应用中直接操作HBase表。

数据读取与写入优化

在Spark与HBase交互时,数据读取和写入的优化是提高效率的关键。

数据读取优化

以下是一些数据读取优化的策略:

使用过滤条件:在读取数据时,应用过滤条件可以减少从HBase读取的数据量,从而提高读取效率。

批量读取:通过批量读取数据,可以减少网络传输和HBase服务器的请求次数,提高读取速度。

合理设置扫描范围:合理设置扫描范围,避免扫描不需要的数据,减少I/O操作。

数据写入优化

以下是一些数据写入优化的策略:

批量写入:批量写入数据可以减少写入次数,提高写入效率。

优化写入策略:根据业务需求,选择合适的写入策略,如单行写入、批量写入等。

合理设置内存缓冲区:适当调整内存缓冲区大小,可以减少写入延迟。

数据分区与并行处理

Spark的分区机制可以帮助优化HBase的数据处理性能。以下是一些分区与并行处理的策略:

使用HBase分区键:在HBase中,可以使用分区键对数据进行分区,Spark可以根据分区键将数据分配到不同的分区中,从而实现并行处理。

自定义分区函数:根据业务需求,自定义分区函数,将数据分配到不同的分区中,提高并行处理能力。

调整分区数:合理调整Spark的分区数,可以充分利用HBase集群的计算资源,提高处理速度。

性能监控与调优

在Spark与HBase集成过程中,性能监控与调优是保证高效处理的关键。

性能监控

以下是一些性能监控的方法:

查看Spark UI:通过Spark UI可以实时查看Spark任务的状态、执行时间等信息。

查看HBase监控工具:使用HBase监控工具,如HBase Shell或Phoenix,可以监控HBase集群的运行状态。

性能调优

以下是一些性能调优的方法:

调整Spark配置:根据实际业务需求,调整Spark的配置参数,如内存大小、线程数等。

优化HBase配置:根据HBase集群的运行情况,调整HBase的配置参数,如RegionServer的线程数、BlockCache大小等。

数据预热:在处理大量数据前,对HBase进行预热,以提高后续处理的效率。

结论

Spark与HBase的结合为大数据处理提供了强大的解决方案。通过合理配置、优化读写操作、数据分区与并行处理,以及性能监控与调优,可以显著提高Spark与HBase的协同工作效率。在实际应用中,根据具体业务需求,不断调整和优化,以实现最佳的性能表现。

转载请注明来自东营众达包装有限责任公司,本文标题:《spark写hbase高效:hbase+spark 》

鲁ICP备2020041603号-1

鲁ICP备2020041603号-1

还没有评论,来说两句吧...